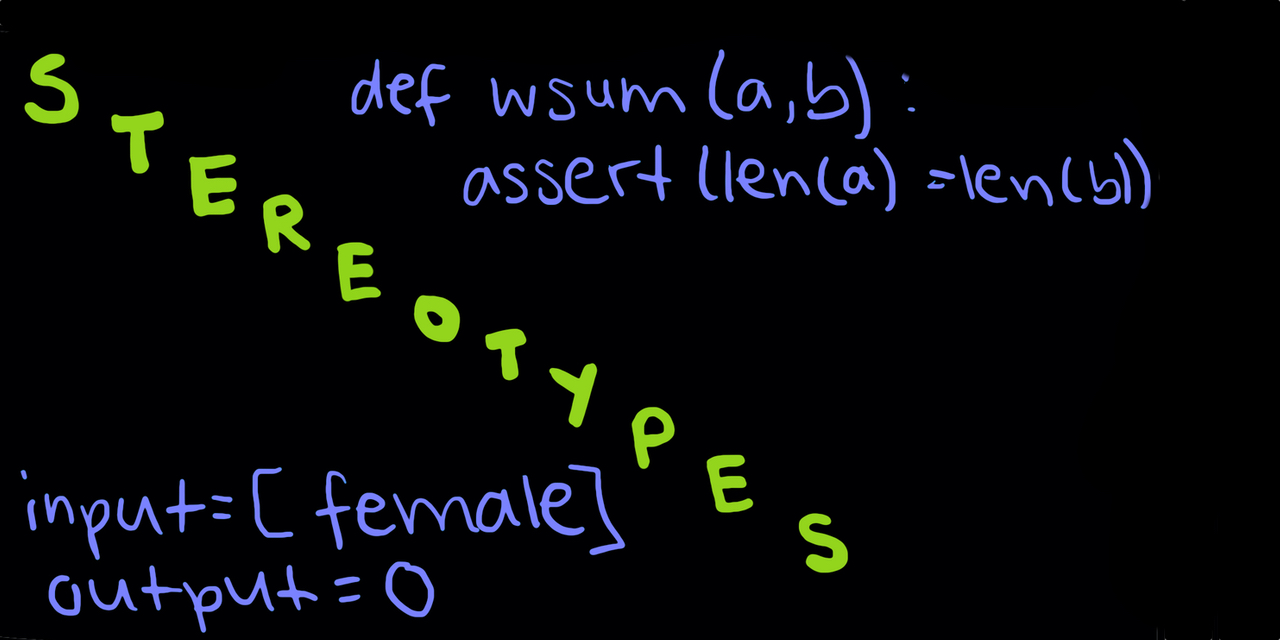

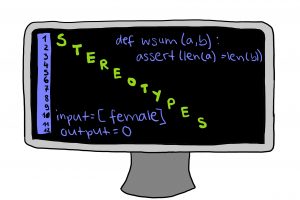

Linksliberale preisen gerne den Fortschritt. Auch den technologischen. Schließlich kann grüne künstliche Intelligenz einen wesentlichen Beitrag zur Abmilderung der Klimakrise beitragen. Auch das Arbeitsleben kann mit ihr ganz anders gedacht und strukturiert werden. So die Vision. Allerdings strotzen diese neue Technologien nicht nur von künstlicher Intelligenz, sondern auch von einprogrammierter Diskriminierung. Das zeigt sich deutlich an Amazons „Recruiting Tool“, mit dessen Hilfe im Jahr 2015 Bewerber eingestellt wurden. Dabei vergibt die Künstliche Intelligenz – wie bei Produkten auf Amazon – einen Score zwischen eins und fünf Sternen an den Kandidaten. Leider bekamen Frauen kaum einen Stern ab. Denn Bewerberinnen wurden durch das Recruiting Tool systematisch degradiert (1). Jetzt könnte man meinen, das Tool sei einfach schlecht programmiert.  Die Krux ist aber, dass eine Künstliche Intelligenz durchaus gute Entscheidungen trifft, aber eben nur nach den zur Verfügung gestellten Datensätzen. Und diese bestanden im Falle des Recruiting Tools von Amazon aus Personalentscheidungen der letzten zehn Jahre, die sich vor allem durch ihre Bevorzugung von Männern auszeichneten. Die Künstliche Intelligenz hat aufgrund der alten Daten gelernt, Frauen im Bewerbungsprozess zu benachteiligen. Das Problem liegt also in der männerdominierten Tech-Industrie, kurz gesagt, in unserer diskriminierenden Gesellschaftsstruktur.

Die Krux ist aber, dass eine Künstliche Intelligenz durchaus gute Entscheidungen trifft, aber eben nur nach den zur Verfügung gestellten Datensätzen. Und diese bestanden im Falle des Recruiting Tools von Amazon aus Personalentscheidungen der letzten zehn Jahre, die sich vor allem durch ihre Bevorzugung von Männern auszeichneten. Die Künstliche Intelligenz hat aufgrund der alten Daten gelernt, Frauen im Bewerbungsprozess zu benachteiligen. Das Problem liegt also in der männerdominierten Tech-Industrie, kurz gesagt, in unserer diskriminierenden Gesellschaftsstruktur.

Wie tief sexistisch und rassistisch solche Algorithmen sein können, wurde schon sehr früh von People of Color, insbesondere von schwarzen Frauen kritisiert. Erst sehr spät wurde diese Kritik berücksichtigt. Beispielsweise bei der Gesichtserkennung, die unter anderem auch zur polizeilichen Verdachtskontrolle eingesetzt werden kann.

Während die Gesichtserkennung für weiße Männer sehr gut und für weiße Frauen gut funktioniert, erkennt sie nicht-weiße Männer schlecht und nicht-weiße Frauen sehr schlecht. Die Informatikerin und Aktivistin Buolamwini erforschte, dass die Fehlerrate bei weißen Männern nie über 0,8 Prozent lag, die von schwarzen Frauen allerdings bei bis zu 34 Prozent (2).

Warum ist das so? Weil der Technologie überproportional viele weiße Männergesichter zum trainieren gegeben wurden. Solche Datensätze halten folglich der Gesellschaft den Spiegel vor, sind dabei aber nicht zwingend neutral, repräsentativ und fair.

Ein aktueller Fall zeigt das in voller Härte: Der Kopf der US-Abgeordneten Alexandria Ocasio-Cortez wurde einem Programm eingespielt, das die Aufgabe hatte, den Körper automatisch zu vervollständigen. Mit anderen Worten: der Körper der Frau soll mit passenden Pixeln zu dem vorgegebenen Kopf generiert werden. Wohingegen der Kopf eines Mannes zu 43 Prozent mit dem Körper eines Anzugträgers vervollständigt wurde, wurde die US-Abgeordnete von dem Programm in einem Bikini dargestellt (3). Warum ist das so? Die Antwort ist dieselbe: weil die Technologie mit Fotos aus dem Internet gefüttert wurde und dort nun mal überdurchschnittlich viele Männer Anzug und überdurchschnittlich viele Frauen Bikinis tragen. Welcome to the Male Gaze.

Wer also das Wort „Algorithmus“ in den Mund nimmt, muss auch das Wort „voreingenommen“ aussprechen.

Das ist definitiv keine neue Erkenntnis, dennoch fehlt es an Anerkennung und Wertschätzung für jene, die dieses Problem angehen. Und das tun einige. So laden die Herausgeberinnen des Podcasts „Radical AI“ verschiedene Gäste aus der Tech-Branche ein, um mit ihnen über gerechte Zukunftsvisionen und aktuelle Diskriminierungsmuster zu sprechen. Das „Black Professionals in Tech Network“ kämpft ebenfalls gegen die weiße Männerdomäne an und Safiya Umoja Nobl schrieb das Buch „Algorithms of Oppression: How Search Engines Reinforce Racism“ (4). Das sind nur drei Beispiele aus einem Meer von Aktivist*innen, die für diskriminierungsfreie Algorithmen und mehr Diversity in MINT-Berufen kämpfen. Dabei ist ihnen bewusst, dass Technologien wandelbar sind und zunächst in den Händen der Entwickler*innen liegen. Diese müssen ihre Verantwortung anerkennen, Algorithmen so zu gestalten, dass sie tatsächlich zum Aufbau einer gerechteren und zukunftsfähigen Welt beitragen.

Beim Thema „Künstliche Intelligenz“ und „Algorithmen“ verhält es sich wie in allen anderen Bereichen auch: “’Fixing’ discrimination in algorithmic systems is not something that can be solved easily. It’s a process ongoing, just like discrimination in any other aspect of society”(Andrew Selbst, Data&Science (5)).

Quellen:

(1) https://www.theguardian.com/technology/2018/oct/10/amazon-hiring-ai-gender-bias-recruiting-engine

(2) https://www.bptn.ca/blog/facial-recognition-bias-against-black-women/

(3) https://www.technologyreview.com/2021/01/29/1017065/ai-image-generation-is-racist-sexist/

(4) Algorithms of Oppression How Search Engines Reinforce Racism (Englisch) Taschenbuch – Illustriert, 20. Februar 2018

(5) https://www.technologyreview.com/2019/02/04/137602/this-is-how-ai-bias-really-happensand-why-its-so-hard-to-fix/