Mehr als 1000 Euro für das aktuelle iPhone XS – ein modernes Smartphone kostet heute genauso viel wie ein ausgewachsenes Notebook mit schnellem Prozessor und viel Speicher. Der Grund dafür ist zum einen die große Gewinnspanne der Hersteller. Ein Smartphone steht heute aber auch in Sachen Leistung einem traditionellem Büroklotzrechner oder einem schicken Notebook in nur noch wenigen Dingen nach. Wir tragen einen Hochleistungsrechner in unseren Hosentaschen.

Aber wofür das Ganze? Glaubt man das, was ältere Männer auf den Keynote-Bühnen von Apple und Samsung vom Teleprompter ablesen, dann braucht man die gigantische Rechneleistung für „AI“, also für Künstliche Intelligenz oder Maschinelles Lernen (ML). Das ist in Apple’s Sprache awesome, magical, incredible und never seen before zugleich.

ML war vor wenigen Jahren noch ein ziemlich schwergewichtiges und nerdiges Thema. Traditionell hatte man in der alten IT-Welt Probleme mit deterministischen, also klar und starr definierten Programmen gelöst. Bei ML ist das anders. Hier wird die Generalisierung eines Musters nicht vom Programmierer vorgegeben, sondern Schritt für Schritt von der Maschine selbst vorgenommen. Der Programmierer hat dafür nur einen Meta-Algorithmus geschrieben oder in den meisten Fällen einen bereits bestehenden nur verwendet und konfiguriert. Für die eigentliche Anwendung genügt dann oft, nur das Ergebnis dieser maschinellen Lernerei (das ML-Modell) auswerten zu müssen.

Rechnerische Höchstleistung fürs Selfie

Und das alles ist heute bereits Bestandteil von Standardfunktionen eines modernen Smartphones. Jedes Foto das auf einem aktuellen iPhone geschossen wird, durchläuft eine ganze Kaskade von ML-Optimierungen, um das Instagram-Selfie besonders likeable werden zu lassen. Den Minilinsen der Kameras sind nämlich physikalische Grenzen gesetzt. Und diese Grenzen lassen sich mit Rechenkraft viel leichter aushebeln als mit der Weiterentwicklung der mechanischen und optischen Komponenten — vielleicht auch deshalb, weil sich Ingenieure inzwischen viel besser mit Software auskennen als mit Materie, die man anfassen kann. Die Tiefenunschärfe und der Bokeh-Effekt der neuen iPhones ist eigentlich ein Software-Feature und hat zumindest technisch mit dem optischen Effekt vollwertiger Kameras rein gar nichts zu tun. Die Liste lässt sich fortsetzen: Die Suche in den Fotos (“Hey Siri, zeig mir Fotos von meinem Abendessen”), das Zusammenstellen von Fotos zu einer thematisch passenden Collage, das automatische Schneiden von selbst aufgenommenen Filmen zu möglichst interessanten Clips — all das fordert mehr und mehr Rechenpower wegen dem ML. All die neuen Apps, die mit Augmented Reality Nützliches oder Unnützes umsetzen, funktionieren ebenfalls zu großen Teilen mit ML.

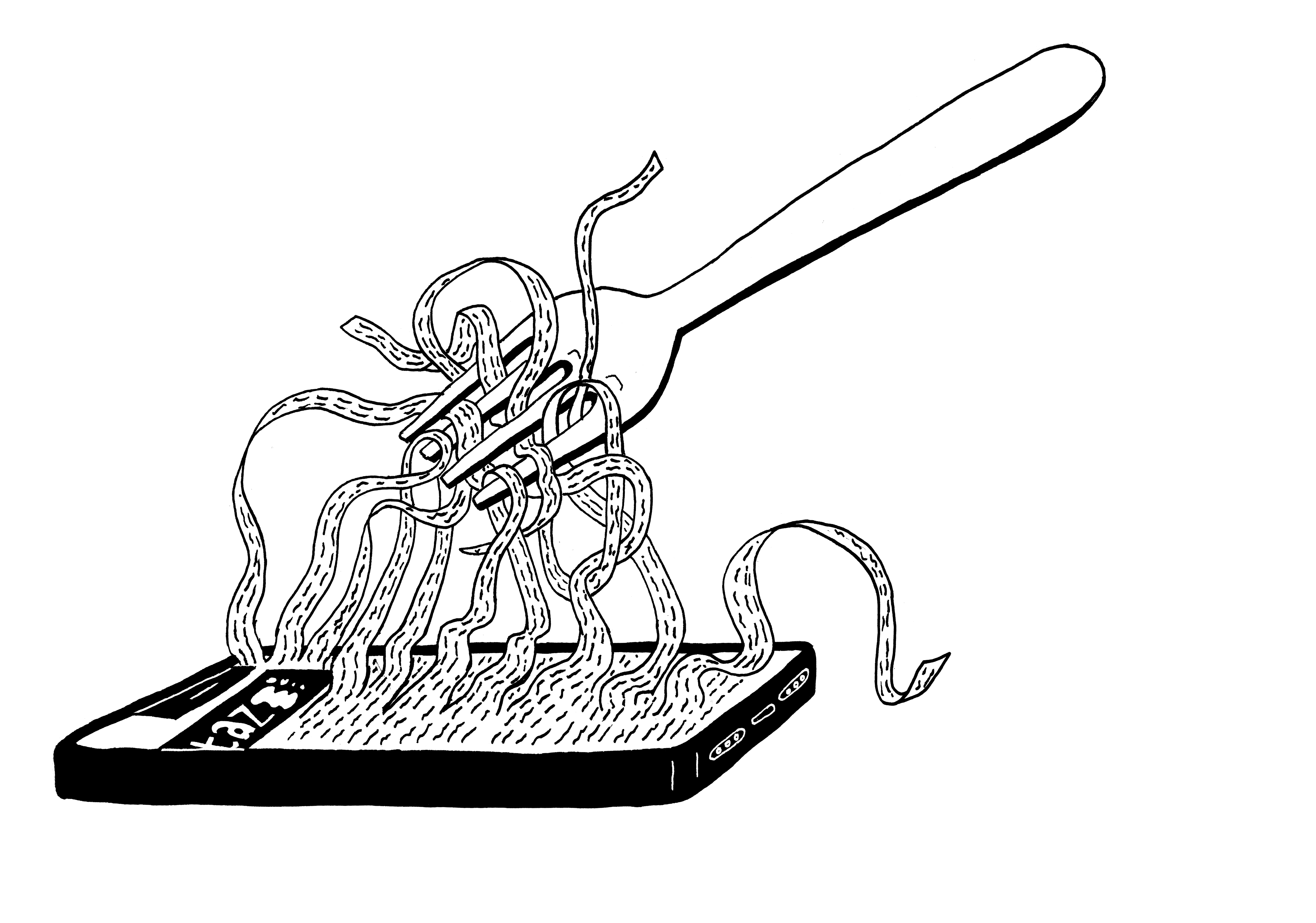

Edge Computing für ein Mindestmaß an Privatheit

Aber besonders dann wenn es um private Bilder und Videos geht, muss eine Maxime gelten: Nicht nur möglichst viel, sondern alle Funktionalität der künstlichen Intelligenz muss auf dem Smartphone stattfinden — und nicht auf einem Großrechner im Internet. Das Gegenkonzept ist, alle Daten erstmal zu einem Anbieter zu laden und dann in dessen Rechenzentrum die Bildoptimierung durchzuführen. Google ist hier großer Vorreiter dieser zweifelhaften Methode. Von der Action-Cam Google Clips aufgenommene Daten werden unmittelbar zu Google geladen, um dann dort die besten Momente in der Cloud zu identifizieren. Ein großer Preis: Für ein paar lustige Videos vom eigenen Hund werden potenziell intime Einblicke ins private Leben erstmal ins Internet gestellt.

Verschlüsselung kann hier keine Abhilfe schaffen. Der reine Transport der Daten kann verschlüsselt werden, sodass zumindest unterwegs kein Angereifer den Videostream abgreifen kann. Zur eigentlichen Analyse im Rechenzentrum muss das private Video und das private Foto aber unverschlüsselt vorliegen. Und es ist ziemlich sicher, dass ein Algorithmus, der Bananen von Aprikosen unterscheiden kann, auch bei anderen Bildinhalten äußerst zuverlässig funktioniert.

Deshalb muss der Algorithmus und vor allem sein Ergebnis auf dem Smartphone bleiben. Das wird oft abwertend und abgrenzend als Edge Computing bezeichnet — gleichsam so als wäre das Smartphone im Gegensatz zur Cloud die minderwertige Option. Ist sie aber nicht, denn das lokale Rechnen garantiert ein letztes Mindestmaß an Privatheit und Sicherheit.

Maschinelles Lernen wird, ob sinnvoll oder nicht, für die nächste Zeit das Werkzeug sein, mit dem wir alltägliche, wissenschaftliche und vielleicht auch lebensrettende Konzepte algorithmisch umsetzen werden. Und wenn dabei private Daten im Spiel sind, darf das nicht auf irgendwelchen Rechnern passieren. Und das geht nur, wenn die Smartphones nachhaltig schneller und besser werden.

Ich stimme völlig zu, dass vieles von diesem KI Zeug lokal laufen muss. Ich will keine Alexa zuhause, aber snips.ai sieht durchaus interessant aus.

Edge Computing ist leider nicht die Lösung für alles. Interessant ist für Cloud-Angebote allerdings Intels SGX. Damit muss ich nicht mehr dem Cloud-Anbieter vertrauen sondern „nur“ noch der Intel-Hardware die dort in der Cloud läuft. Signal schafft es mit diesem Trick zum Beispiel, dass das Addressbuch eines Benutzers mit der Liste aller Signal-Benutzer abgeglichen wird ohne dass Signal das Addressbuch erfährt und ohne dass der Benutzer alle Signal-Benutzer erfährt. https://signal.org/blog/private-contact-discovery/