1943. In Europa wütet der Zweite Weltkrieg und das Töten scheint kein Ende zu nehmen. In den USA erstellen der Neurophysiologe Warren McCulloch und der Logiker Walter Pitts ein mathematisches Modell, das McCulloch-Pitts-Neuron. Ohne dieses Modell wären künstliche Intelligenzen wie ChatGPT völlig undenkbar. Ich habe eine ganz dumme Frage: Ein Neuron ist eine Nervenzelle, viele davon ergeben ein Gehirn. Was haben Nervenzellen mit einem mathematischen Modell zu tun? Wo ist da der Berührungspunkt?

Nun, die Frage lässt sich auf zwei Weisen beantworten. Die kurze Antwort lautet, das mathematische Modell eines Neurons ist im weitesten Sinne eine Formulierung, wenn man so will eine Beschreibung, der Funktion eines Neurons in Begriffen der Mathematik. Kurzum, was passiert, wenn das und das passiert. Ein Neuron, also das reale, hat Verbindungen zu anderen Neuronen und ein bestimmtes Verhalten in bestimmten Umständen. Diese Umstände sind dadurch definiert, was an den eingehenden Verbindungen an Signalen ankommt. Es gibt also eine bestimmte Menge von Möglichkeiten, was an den — nennen wir es der Einfachheit halber — Eingängen ankommt und eine Menge von Möglichkeiten, was an den entsprechenden Ausgängen — im Modell ist es meistens einer — rauskommt. Wir haben also vereinfacht gesagt eine Zuordnung von Input-Zuständen zu Output-Zuständen. Das klingt doch schon sehr nach Mathe, nicht? Das mathematische Modell beschreibt also diese Relation, die Abhängigkeit des Outputs vom Input. Das ist die vereinfachte kurze Antwort.

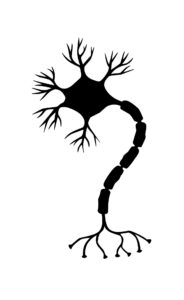

Ich erinnere mich dunkel an meinen Biologieunterricht: Das Neuron sieht ganz entfernt so aus wie ein Baum. Der Stamm ist das Axon. Wenn das Neuron feuert, verwandelt der Baumstamm sich in einen Gewehrlauf. Das ist der Output über den Ausgang. So ein Neuron hat nur zwei Möglichkeiten: Es kann feuern oder nicht. Und ob es das tut oder lässt, liegt an dem, was an Input über die Baumkrone bzw. die Synapsen reinkommt. Jetzt haben wir eine Zuordnung von Input- zu Output-Zuständen. Aber was bedeutet das, wenn eine mathematische Funktion etwas beschreibt?

Das wäre dann der Startpunkt für die lange Antwort auf deine Frage, und da steckt eine Menge von philosophischem Tiefsinn drin. Das Zeugs in der mathematischen Formulierung muss dem Zeugs in der Welt irgendwie zugeordnet werden, es muss dieses in allen relevanten Hinsichten, also im Kern der Sache, treffen. Diese Zuordnung muss sinnvoll motiviert werden und so fort. Im realen Neuron gibt es beispielsweise Membranpotentiale, also Ladungsunterschiede usw., die für die Signalweiterleitung entscheidend sind. Für das Modell fand man mathematische Entsprechungen — numerische Schwellenwerte beispielsweise. Die längere Erklärung ist also die, dass der Berührungspunkt, nach dem Du fragst, in erster Linie die Möglichkeit einer mathematischen Formulierung der realen Welt ist.

Das erinnert mich an meinen großen Aha-Moment in der ersten Klasse: 4 + 2 = 6 kann man auf Bäume, Häuser und Äpfel beziehen. Später ist mir aufgefallen, dass es auch für Birnen, Erdnüsse und Fischstäbchen gilt. Das hatte mich damals sehr fasziniert. Ich erinnere mich genau, wie der Groschen gefallen ist. Aber zurück zu deiner Möglichkeit einer mathematischen Formulierung der Welt …

Genau! Aber hier, beim Einsetzen von Mengen von Gegenständen in Mengenformeln, ist die Sache einfach — die zusammengezählten Sachen müssen unterscheidbar, also individuierbar und abzählbar sein. Aber egal welche vier Gegenstände zu welchen zweien gezählt werden, die Mathe ist da großzügig, am Ende werden es immer sechs sein. Andererseits ist die Sache aber dennoch noch viel komplexer. Ich sprach eben von Membranpotentialen als wäre es etwas, was man in der Welt vorfindet, was natürlich nicht stimmt, es sind bereits theoretische Konstrukte. Das heißt, hier wird eine theoretische Beschreibung der Welt in eine andere, also die mathematische, übersetzt. Nun kann man aufgrund der eben beschriebenen Verwicklung — ich meine die philosophischen Fragen dahinter — fragen, was macht eine mathematische Formulierung adäquat? Oder passend, wirksam, erfolgreich?

Ich versuche mal, eine Antwort zu geben. Mit einem mathematischen Modell kann man beliebig experimentieren, irgendwelche Zahlen einsetzen und schauen, was herauskommt. Wahrscheinlich lassen sich sogar Vorhersagen treffen, wie eine mathematisch modellierte Zelle auf diesen und jenen Input reagiert. Echte Nervenzellen lassen sich viel schwerer handhaben. Man kann mit ihnen experimentieren, sie beobachten, aber nicht berechnen.

Nun, in dieser Hinsicht sind beide Systeme, das natürliche neuronale Netzwerk und das künstliche, sehr ähnlich, sprich uneinsehbar und gleichermaßen be- oder eben unberechenbar. Was die Handhabung anbelangt, stimmt es, reale Neuronen mit kontrolliertem Input zu bespielen, ist eher etwas, was in der Zukunft erst ansteht; nicht der allerfernsten Zukunft, weil auch daran — man denke an neuro-enhancement und brain-computer interfaces — gearbeitet wird. Was die von dir genannte Vorhersagbarkeit angeht, so ist es seltsamerweise anders als man es erwarten würde. Ein Neuron reagiert so wie seine mathematische Modellierung es bestimmt. Bei einer Handvoll, wird es schon komplex. Bei einem umfangreichen Netzwerk war es das mit Prognosen und erwartbaren Resultaten.

Ein alter Schulfreund von mir hat Physik studiert. Er hat mir mal erklärt, dass sich ein einfaches Pendel ganz einfach mit Newtons Physik berechnen lässt. Aber schon bei einem Doppelpendel wird es sehr, sehr kompliziert. So ähnlich ist es dann wohl auch mit den Neuronen: Obwohl ein einzelnes Neuron komplett starr und mechanisch reagiert, ist ein Netzwerk von Neuronen für uns nicht mehr vorhersagbar. Aber zurück zu den mathematisch modellierten Neuronen von McCulloch und Pitts: Warum ist dieses mathematische Modell so adäquat, passend und wirkungsmächtig? Worin liegt das Geheimnis seines Erfolgs?

Die Crux ist, dass unsere Computer auf unterster Ebene reine Rechenmaschinen sind, sie führen einfache Rechnungen mit Binärzahlen durch. Der Vorzug von mathematischen Modellierungen liegt nun hoffentlich auf der Hand: Computer können — einfach gesagt — mit ihnen umgehen. Man kann also das mathematische Modell als einen Zwischenschritt auf dem Weg von einer realen Sache zu ihrer artifiziellen Nachbildung interpretieren. Einer bestimmten Art Nachbildung unter vielen, nämlich einer Simulation.

Verstehe ich das richtig: McCulloch und Pitts haben eine Nervenzelle mathematisch beschrieben und dann auf dem Papier mit Formeln, Zahlen und Buchstaben ein Geflecht von Nervenzellen simuliert? Da muss man erst einmal drauf kommen!

Ja und nein, es ist die Zeit, da an Rechenmaschinen gearbeitet wird, die ersten bis heute gültigen Rechnerdesigns entstehen und so fort. John von Neumann begründet sowohl die mathematische Spieltheorie wie auch die mathematische Ökonomie und entwirft mal nebenbei die nach ihm benannte Rechnerarchitektur. Zudem weiß die Physik seit Galileos berühmtem Diktum, dass »das Buch der Natur in der Sprache der Mathematik geschrieben ist«. Dann werden in dieser Zeit zwei mathematisch verschiedene, aber äquivalente Beschreibungen der Quantenmechanik entwickelt … Kurzum, es lag schon sehr nahe, hier eine mathematische Formulierung zu versuchen. Aber es gäbe ja auch andere Nachbildungen, man könnte das Neuron etwa auch aus chemischen Komponenten nachbauen wollen. Es gab mal Ansätze — allerdings erst 50 Jahre später — die sich wetware computing nannten, bei welchen aus echten Neuronen Rechner gebaut wurden.

Simuliert haben sie meines Wissens nichts; allenfalls mal was durchgespielt.

Kannst du mal bitte versuchen, das Besondere dieses McCulloch-Pitts-Neurons auf den Punkt zu bringen?

Die große Leistung von McCulloch und Pitts ist die Tatsache, dass die Formulierung in der abstraktesten Sprache, die wir haben, für die universellsten Werkzeuge, die wir haben, »verständlich« ist, und dadurch wirksam und ungeheuer erfolgreich. Wenn das mit Adäquatheit gemeint ist, dann ist das Modell zudem sehr adäquat. Technisch kommt die ganze Sache mit dem McCulloch-Pitts-Neuron als ein mathematischer Kalkül daher. D.h. es ist per se fürs Herleiten von Aussagen gemacht und damit das, was wir mit jedem anderen Kalkül so machen; du etwa mit dem 4+2=6 im Kalkül der Arithmetik. Die Neuronen sind darin überraschenderweise viel universeller und mächtiger als etwa unsere Äquivalente im Logik-Kalkül …

Moment mal! Die universellsten Werkzeuge sind die Neuronen und die abstrakteste Sprache, die für Äpfel, Birnen und Bäume gilt, das ist die Mathematik. Was für ein Geniestreich!

Das mit den Werkzeugen als solchen wäre noch zu untersuchen. Vielleicht sind die Neuronen die universellsten Bausteine, aus welchen man maximal universelle — im weitesten Sinne — Werkzeuge zusammensetzen kann, das schon. Und in Sachen Geniestreich, gehe ich mit. Das war schon etwas Außerordentliches! Und dass es eine Zeit gedauert hat, bis das volle Potenzial erkannt und zur Realisierung gebracht wurde, spricht auch dafür, dass McCulloch und Pitts ihrer Zeit Dezennien voraus waren. Zwar bedurfte es noch einiger technischer Umwälzungen und mathematischer Fortschreibung des Modells, bis zur Entfaltung der uns heute verblüffenden Leistungsstärke der großen Netze dieser modellierten Neuronen, doch im Kern ist das McCulloch-Pitts-Neuron der Startpunkt.

Haben die dafür wenigstens den Nobelpreis bekommen?

Tja, wofür hätte es den geben sollen? Allenfalls Medizin/Physiologie, aber da war die Welt und das Nobelkomitee noch nicht so weit, mathematische oder rein theoretische Durchbrüche in den Nobel-Disziplinen zu würdigen. Nebenbei gesagt, war Walter Pitts gerade mal zwanzig, als er das Paper schrieb — und im Wesentlichen schrieb er es. Er war zudem ein akademischer Außenseiter und Überflieger zugleich. Das sind allerschlechteste Voraussetzungen auch nur für den bedeutungslosesten Preis, geschweige denn echte Auszeichungen. Immerhin haben die Leute, die ab den 1980ern das Ganze weiter gedacht haben und wesentliche Neuerungen beförderten, den Turing-Award eingeheimst. Ist ja irgendwie fast besser als ein Nobelpreis.

Nochmal zurück zu den neuronalen Netzen. So ein neuronales Netz ist überraschend mächtig. Es kann zum Beispiel Informationen speichern. Ich habe im Deutschlandfunk mal eine Reportage gehört, dass man zum Beispiel die Bibel auch in Form einer Gensequenz abspeichern kann. Es gibt also mehrere Arten, um Informationen zu codieren und aufzubewahren. Für mich klingt das wie Science Fiction. Aber ich bin abgeschweift. Der Punkt ist: Künstliche und natürliche neuronale Netzwerke und unsere Buchstaben und Zahlen sind verschiedene Arten, um etwas aufzuschreiben.

Und diese Notationen sind mathematisch äquivalent! Der ganze Themenkomplex der Notation bzw. der Repräsentation der Information ist oberflächlich ein technischer Punkt. Jedoch verbirgt sich dahinter — wie so oft — eine tiefgründige philosophische bzw. anthropologische Frage.

Welche denn?

Seit jeher forschen wir daran, wie nun Informationen in Hirnstrukturen repräsentiert werden — und scheitern natürlich. Gemeint ist dabei nicht nur Erinnerung, Information und dergleichen, sondern auch aktueller Input, etwa Sinneswahrnehmung usw. Eigentlich gilt: Jede Information kann in jede Repräsentation überführt werden — und darin auch verarbeitet werden! Von der Realisierung der Repräsentation hängt die physisch mögliche Verarbeitung ab.

Moment! Wenn ich die Aufgabe 7 x 3 gestellt bekomme, übersetzt mein Gehirn diese Zahlen in ein Erregungsmuster meines natürlichen neuronalen Netzes und spuckt dann die Lösung aus, die ich irgendwann in der Grundschule gelernt habe.

Ja, das wäre ein Beispiel für codierte und wieder hervorgeholte statische Information. Dein neuronales Netzwerk könnte es aber auch tatsächlich berechnen! Bei 33 x 77 hast du wahrscheinlich kein gespeichertes zugeordnetes Ergebnis, dafür aber eine Routine, wie zu diesem zu gelangen ist. Da du die DNA angesprochen hast: Leonard Adleman hat schon in den 90ern gezeigt, dass man mit DNA rechnen kann und zwar richtig rechnen. Sein »DNA-Rechner« löste mehrere nicht triviale Rechenaufgaben. Dazu gehört auch eine Speicherung der Ergebnisse oder Zwischenergebnisse oder auch des Algorithmus usw. Da hat der Deutschlandfunk also recht — und nicht nur auf die Bibel bezogen.

Ein DNA-Rechner, das ist ja verrückt.

Es spricht aber für eine bestimmte Eigenschaft der Information und der Beschaffenheit der Welt. Man kann etwa auch Shakespeares Hamlet in einer Abfolge von Miau-Lauten codieren oder mit Murmeln im feuchten Sand — viele Murmeln und riesiger Sandkasten, versteht sich. Ich folgte dir eben beim Abschweifen, weil sich hier ein zentraler Punkt verbirgt, der auch für die KI wichtig ist, nämlich die Universalität der Repräsentation. Die DNA hat sich angeboten, weil da auch fertige Prozeduren — sprich Verarbeitungsprozeduren wie zwischenspeichern, vervielfältigen, zusammenführen usw. — implementiert sind, nicht nur eine reine Codierungsroutine.

Angenommen ich habe den Hamlet mit vielen Murmeln im Sandkasten repräsentiert, schön und gut, aber mit der gekürzten Neuübersetzung wird es schwierig.

Die Effektivität der Verarbeitung und Erfassung ist eine andere Sache. Den Hamlet wieder aus den vielen Murmeln, die man in feuchten Sand eingedrückt hat, herauszulesen, ist nicht trivial. Die Codierungsroutine ist ineffektiv und weitere Verarbeitung auch irgendwie beschwerlich. Das Verhältnis von Herstellung der Informationsbevorratung und dem Zugriff auf diese zu der Einfachheit der Manipulation ist der Angelpunkt der Effektivität jeder Informationsverarbeitung; wozu selbstverständlich auch das Denken zählt.

Lass uns mal die Effektivität von Codierung, Informationsbevorratung und Datenverarbeitung vergleichen. Der Murmel-Sandkasten schneidet miserabel ab. Aber welche Sorte von neuronalen Netzen ist überlegen? Die biologischen Neuronen in unserem Kopf oder die neuronalen Netze, die wir dank McCullochs und Pitts mathematischem Modell in Rechenzentren nachbauen können?

In unserem Gehirn ist die Speicherung und die Manipulation bzw. Verarbeitung unerreicht effektiver als in jeder anderen Struktur. Allerdings ist mit dem McCulloch-Pitts-Modell eine Übertragung in Strukturen möglich geworden, an deren technischer Fortentwicklung und Perfektionierung wir ständig werkeln.

Das heißt, unser Gehirn ist zwar besser, aber fertig entwickelt. Die künstlichen neuronalen Netze sind zwar schlechter, aber da geht noch was.

Wie gesagt, unsere neuronale Verarbeitung ist gerade noch unerreicht effektiv. Dass sich das ändern wird bzw. gerade im Begriff ist, sich zu verändern, sieht man an jeder neuen Fortschrittsmeldung aus der KI-Forschung. Die mit unserem Hirn konkurrierende Hardware kann also erst einmal beliebig skaliert werden und es spricht im Prinzip nichts dagegen, gigantische Strukturen zu bauen, die es uns potentiell gleicht tun.

»Skalieren« bedeutet also, dass künstliche neuronale Netzwerke die Fähigkeit zum Wachstum haben?

Vielleicht nicht die Fähigkeit, weil das so nach inhärenter Eigenschaft klingt, aber sie haben das Potential. Das ist beileibe keine Wortklauberei! Unsere Gehirne haben die Fähigkeit, eine Zeit lang zu wachsen …

Das können wir ja bei jedem heranwachsenden Kind beobachten …

Genau, gegeben einen evolutionären Bedarf, können auch die Gehirne unserer Spezies in toto, überindividuell sozusagen, wachsen, auch wenn sie es seit geraumer Zeit nicht so recht tun. Das haben neuronale Netzwerke — als unsere Erzeugnisse aus unbelebter Materie — in der Weise nicht, aber eben das erwähnte Potential. Wir, die sie bauen, können sie größer und noch größer bauen. Und das recht schnell und vorerst ohne Leistungseinbußen — im Gegenteil, wir sind in der Phase, da Vergrößerung stets Zuwachs an Leistungsfähigkeit mit sich bringt. Zwar wird auch das einmal eine physikalische Grenze erreicht haben

— oder besser gesagt eine Effizienzgrenze durch physikalische Limitierungen — aber es ist noch lange nicht soweit. Unsere Denk-Hardware hingegen ist bereits das komplexeste an Materie, was es im bekannten Universum gibt. Das heißt, da ist vermutlich in Sachen Komplexitätssteigerung nicht mehr viel zu reißen und streng genommen tut sich physiologisch seit einer halben Million Jahre auch nicht viel. Mit Volumenzuwachs wie bei Serverparks können wir auch nicht aufwarten; jedenfalls nicht kurzfristig, so dass es vorerst bei den anderthalb Litern Denkorgan bleibt.

Wenn wir auf eineinhalb Liter Gehirnmasse beschränkt sind, dann haben wir ja überhaupt keine Chance, uns gegen immer größer und komplexer gebaute künstiche neuronale Netzwerke zu behaupten.

Naja, nicht ganz. Zum einen stellt sich die alles andere als triviale Frage, ob wir uns behaupten müssen und was das überhaupt bedeutet. Es ist mithin eine Entwicklung der KI denkbar, die alles ist, außer bedrohlich. Also in erster Linie nützlich, produktiv, zweckmäßig im allerbesten Sinne erlesen edelster menschlicher Zwecke. (— Und natürlich wird die Entwicklung der KI alles sein außer dieser Utopie, die ich hier skizziere.) Zum anderen können wir das tun, was etwa McCulloch und Pitts taten: Köpfe zusammenstecken zwecks Vervielfachung der intellektuellen Kapazitäten des Individuums. Letztlich ist die unermessliche Steigerung der geistigen Möglichkeiten, die dank KI dem Menschen zur Verfügung steht, etwas, was sich dieser Verbindung zweier echter Hirne verdankt, an welche unzählige weitere anknüpfen konnten. Auch das ist eine Art über die Zeiten und Individuen verteiltes neuronales Netzwerk.

Was für ein schöner Gedanke: Die Menschheit steckt über die Jahrzehnte und Jahrhunderte die Köpfe zusammen und erschafft ein überzeitliches neuronales Netzwerk. Dieses überzeitliche Element hatte mich immer an Literatur fasziniert … Ich habe jetzt eine Ahnung davon, was McCulloch und Pitts sich da ausgedacht haben. Vielen Dank fürs Erklären!

Zum Interviewpartner

Chris Demian ist Wissenschaftsphilosoph und Computerlinguist. Seit er mit dreizehn Jahren nach Deutschland, in »das Land der unbegrenzt verfügbaren Computer« kam, programmiert er. An neuronalen Netzen arbeitete er zum ersten mal vor 28 Jahren, als er im Rahmen von Jugend forscht versuchte, diese mit genetischen Algorithmen zu optimieren.

Bildcollage:

- GDJ: »Gehirn« via pixabay.

- jambulboy: »Kopfsilhouette« via pixabay.

- Chris Demian: Neuronales Netzwerk einiger McCulloch-Pitts-Neuronen.

Bildnachweis:

- Mohamed Hassan: »Neuron« via pixabay.